LLMオブザーバビリティ

AIのパフォーマンス、コスト、安全性、信頼性を監視し、最適化

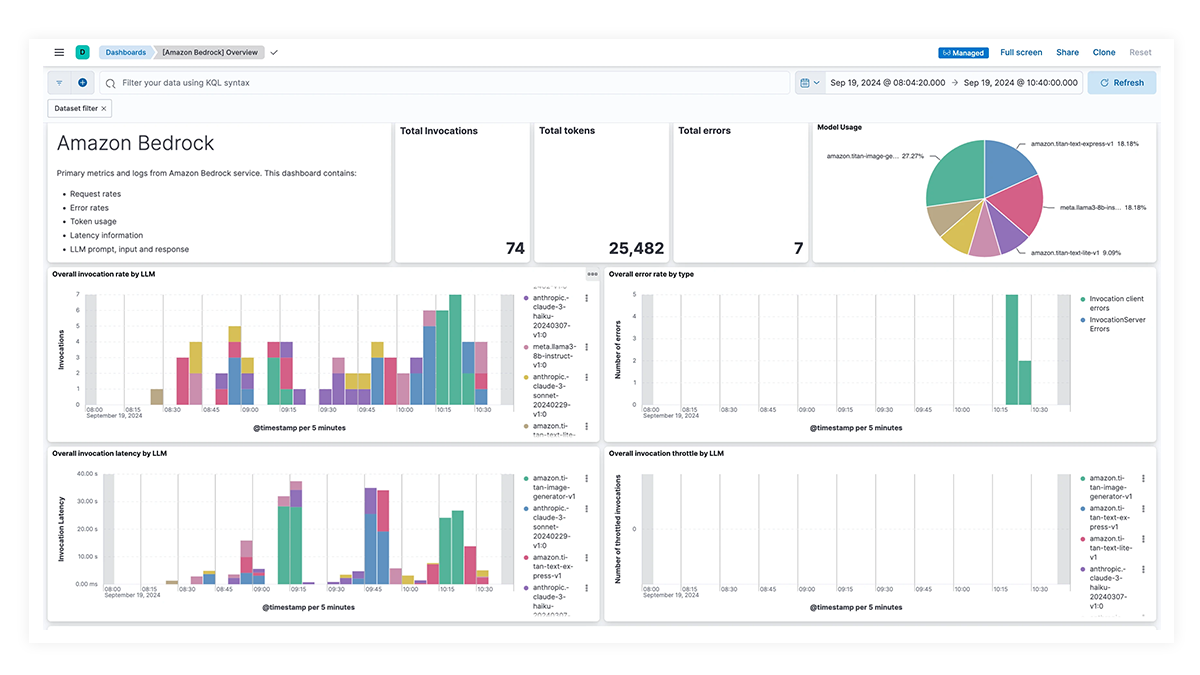

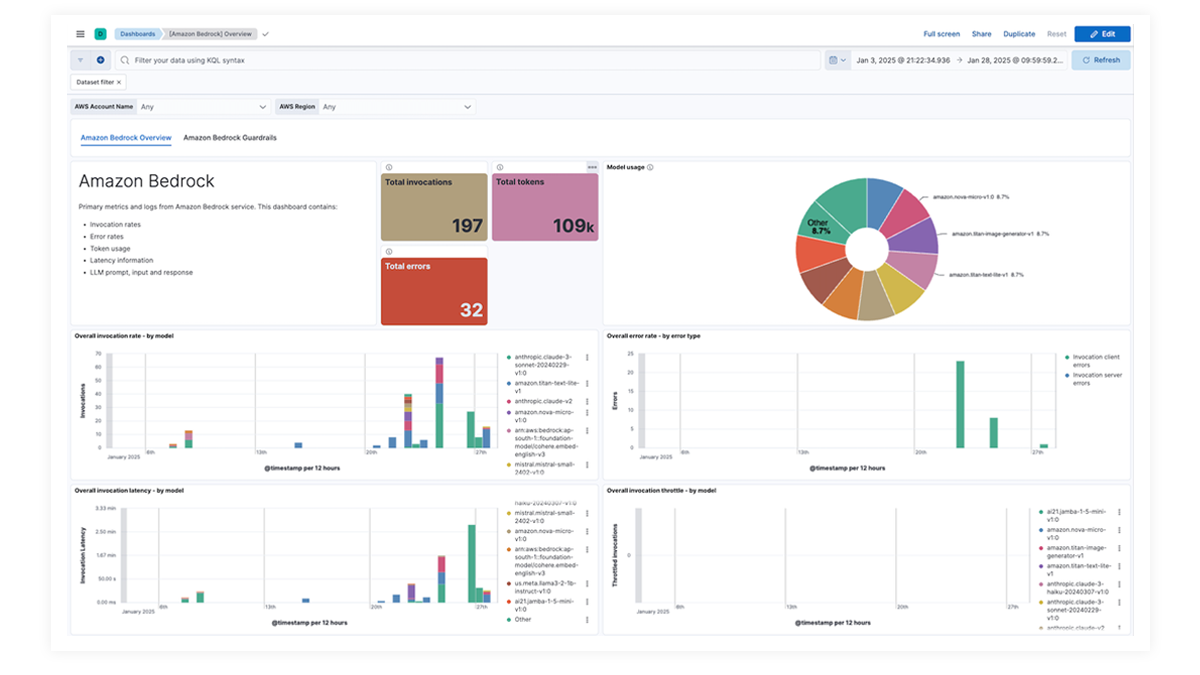

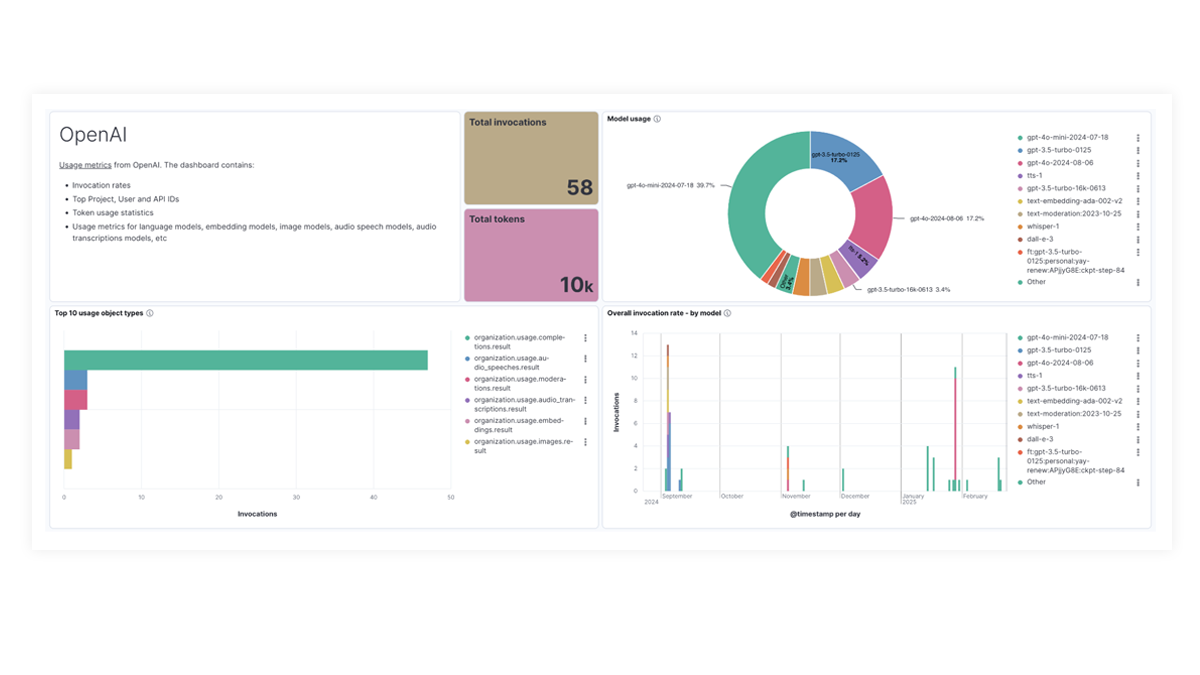

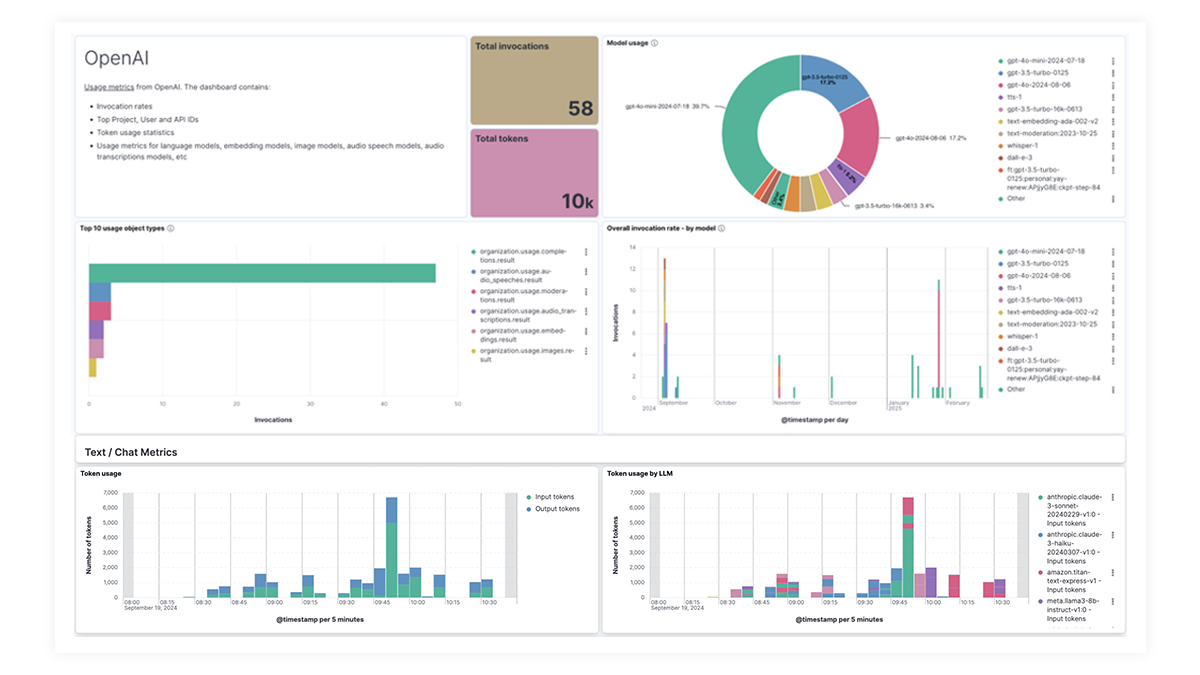

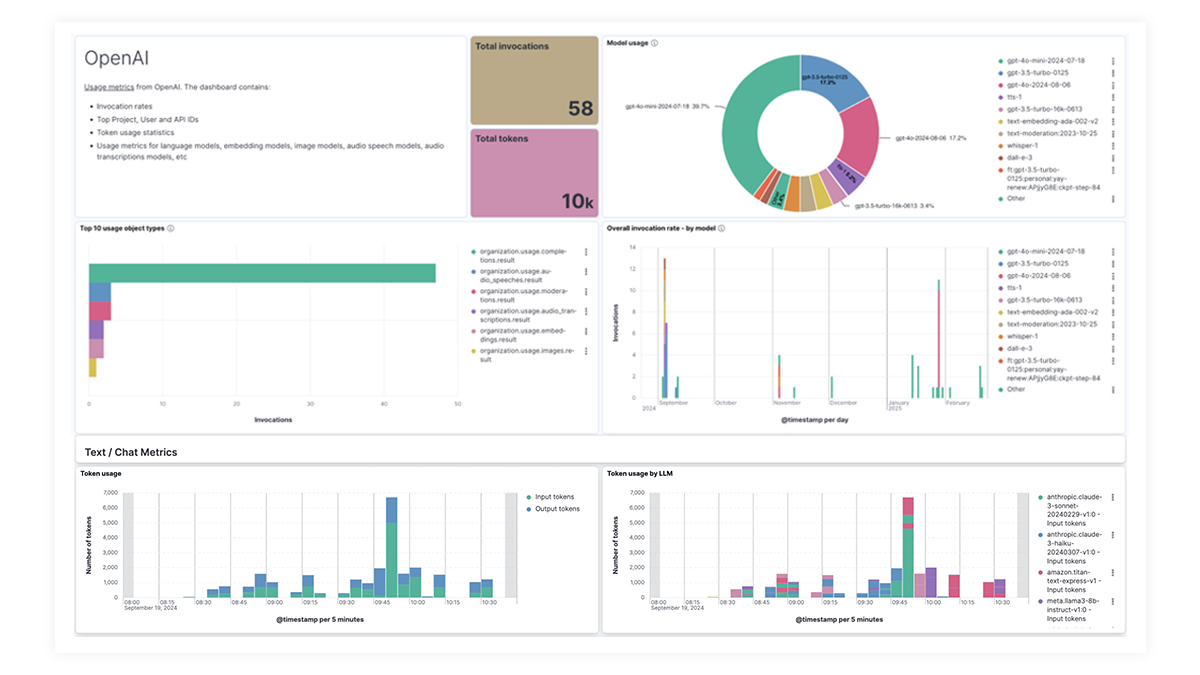

一目でわかるダッシュボードで全体像を把握

OpenAI、AWS Bedrock、Azure OpenAI、Google Vertex AI向けに事前構築されたダッシュボードは、呼び出し回数、エラー率、レイテンシ、使用率メトリック、トークン使用状況に関する包括的な洞察を提供します。これにより、SREはパフォーマンスのボトルネックを特定・対処し、リソース使用率を最適化しながら、システムの信頼性を維持できます。

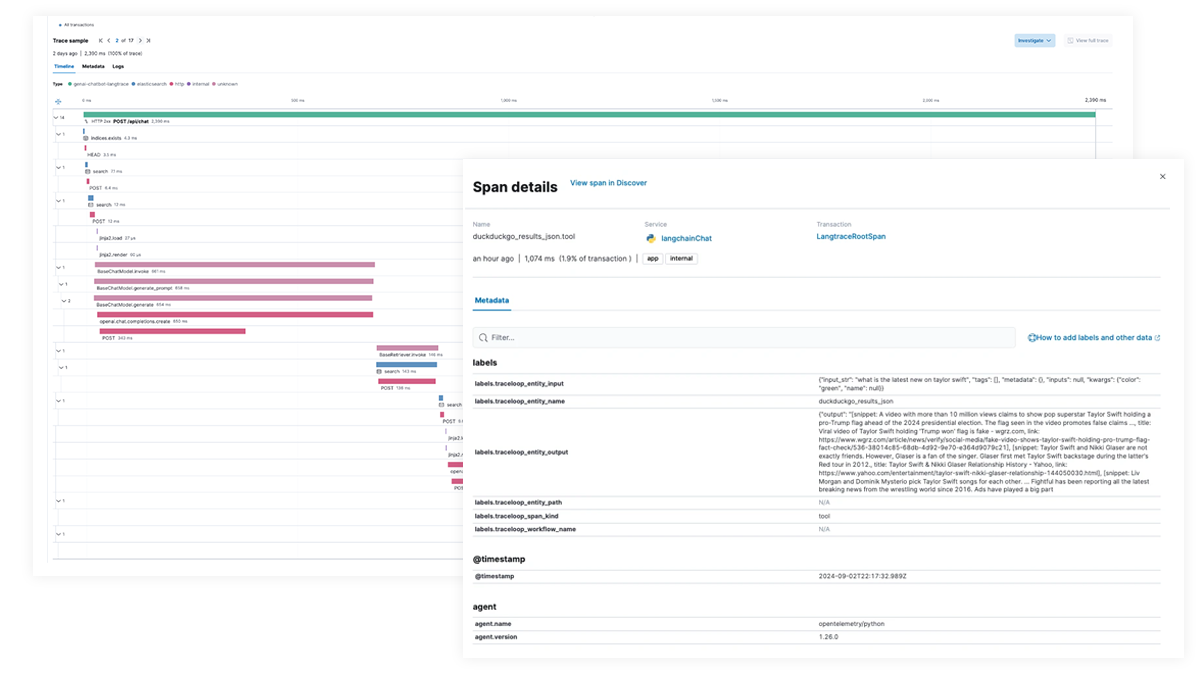

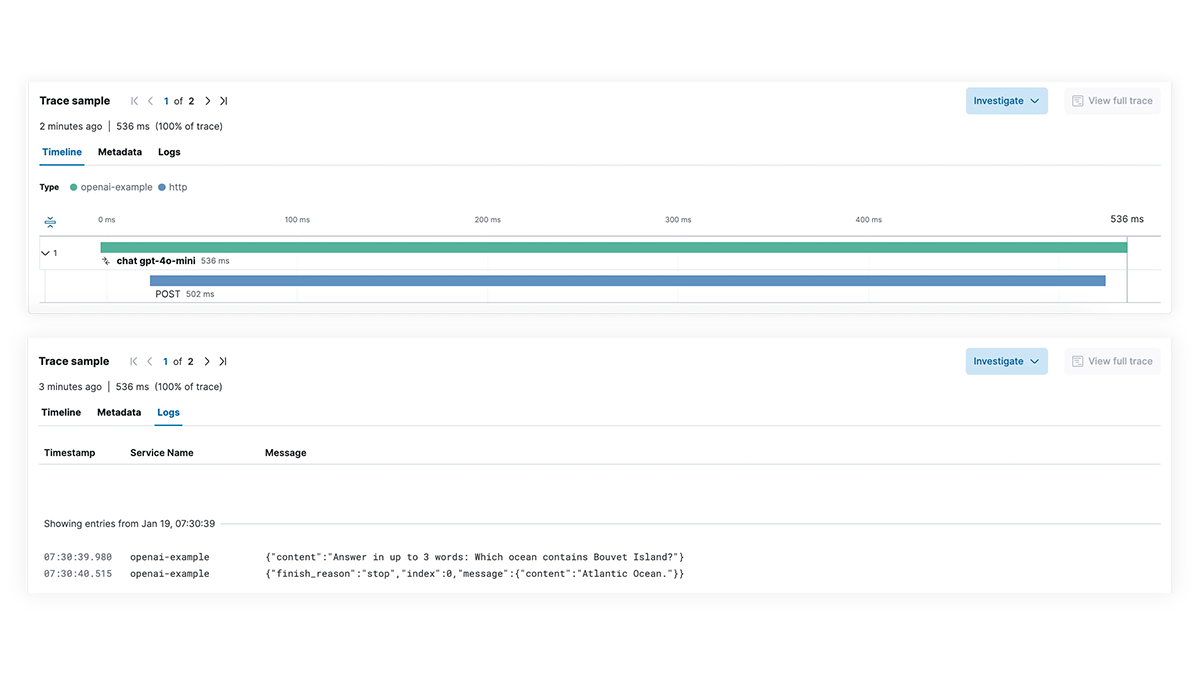

パフォーマンスが遅い場合は根本原因を突き止めましょう

生成AI機能を統合したアプリケーションにおけるLLM実行パスの各ステップを完全に可視化します。エンドツーエンドのトレーシング、サービス間の依存関係のマッピング、LangChainリクエストや失敗したLLM呼び出し、外部サービスとの連携状況の可視化により、より深いデバッグを可能にします。障害や遅延スパイクのトラブルシューティングを迅速に行い、最適なパフォーマンスを確保します。

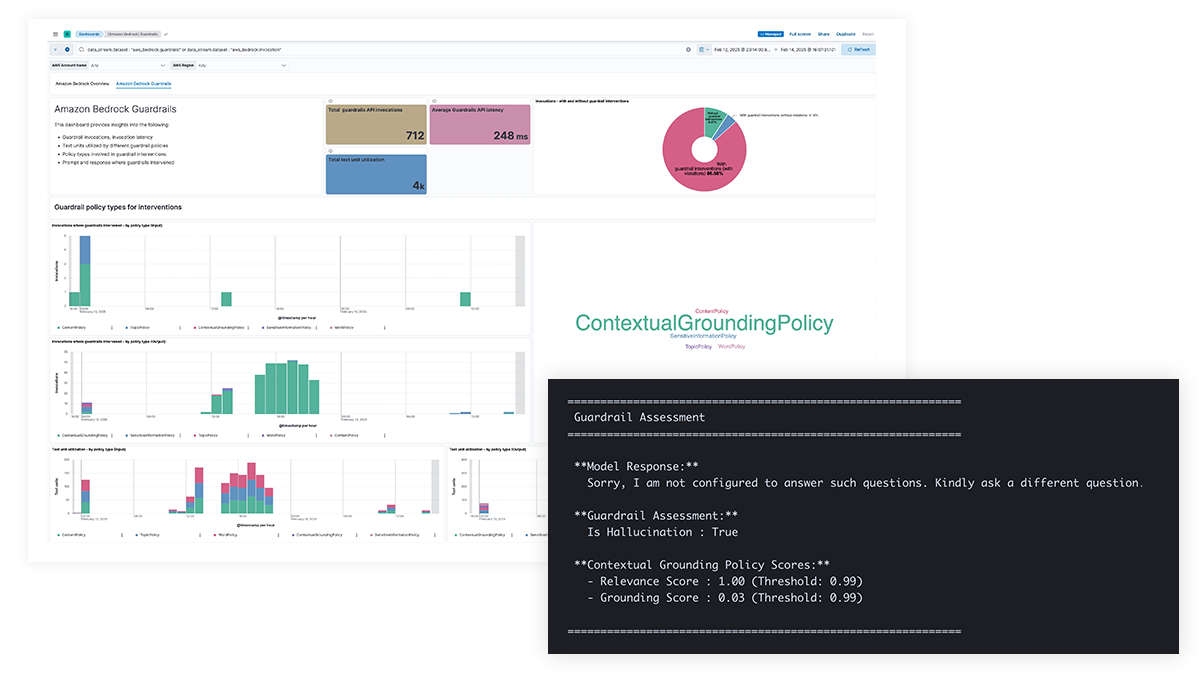

AIの安全性に関する懸念がある場合は、プロンプトと応答を可視化しましょう。

LLMのプロンプトと応答の透明性を高めることで、機密情報の漏洩、有害または不適切なコンテンツ、倫理的な問題を防ぎ、事実誤認やバイアス、ハルシネーションにも対応できます。Amazon Bedrockのガードレール機能やAzure OpenAIのコンテンツフィルタリングのサポートにより、ポリシーに基づく介入が可能になり、文脈に即した補足情報の提供を通じてモデルの精度を高めることができます。

コストの追跡にお困りの場合は、モデルごとの使用量の内訳をご覧ください

組織は、LLMのコストを最適化するために、トークンの使用状況、高コストなクエリやAPI呼び出し、非効率なプロンプト構造、その他のコスト異常を可視化する必要があります。Elasticは、テキスト、動画、画像を含むマルチモーダルモデルに関するインサイトを提供し、チームがLLMのコストを効果的に追跡・管理できるよう支援します。

LLM observability dashboard gallery

The OpenAI integration for Elastic Observability includes prebuilt dashboards and metrics so you can effectively track and monitor OpenAI model usage, including GPT-4o and DALL·E.

EDOTとサードパーティライブラリによるエンドツーエンドのトレース

Elastic APMを使用して、OpenTelemetryを用いたLangChainアプリを分析、デバッグします。これは、EDOT (Java、Python、Node.js) または LangTrace、OpenLIT、OpenLLMetry などのサードパーティのトレースライブラリでサポートできます。

ElasticチャットボットRAGアプリをぜひお試しください!このサンプルアプリは、Elasticsearch、LangChain、さまざまなLLMを組み合わせて、ELSERとプライベートデータを使用してチャットボットを強化します。